(华北电力大学 电气与电子工程学院,北京 102206)

摘 要: 本文提出一种基于VAE-Swin Transformer的输电线异物检测模型,通过VAE与训练框架解决Swin Transformer在输电线异物检测小样本任务中效果欠佳的问题,同时结合改进的双向特征金字塔(EBiFPN)提高了模型在复杂背景以及多尺度目标的检测性能。实验结果表明,本文模型mAP50和mAP75指标上均表现优异,高于Swin Transformer、SSD、和YOLOv5等模型。为为小样本下Swin Transformer的应用以及输电线异物检测提供了新思路。

关键词:输电线异物检测;变分自编码器;Swin Transformer;小样本目标检测

输电线异物会对电力系统造成严重的安全隐患,由于异物为非正常情况,相关图像数据集匮乏且不平衡,应用深度学习技术对输电线异物检测的研究面临挑战[1]。通常目标检测模型采用CNN(Convolutional Neural Network)架构,例如Faster RCNN[2]和YOLO模型[3]。但由于输电线环境复杂和异物尺度多变,传统算法在小目标检测和复杂背景方面仍面临挑战。

Swin Transformer[4]在Transformer[5]的自注意力机制上加入滑动窗口机制提升了特征提取能力,但在小样本训练中面临收敛困难的挑战。现有研究尝试结合自监督学习与高效解码器优化Swin Transformer,但其潜在空间表征能力仍不足,而变分自编码器(VAE)[6]凭借结构化潜在空间和复杂分布学习能力,为提升模型鲁棒性提供了新的改进方向。

本文提出了一种基于VAE-Swin Transformer的输电线异物检测网络,首先,利用VAE的编码、解码结构帮助Swin Transformer提取并重构输电线特征,通过特征迁移使Swin Transformer能在小数据集上通过微调高效捕捉异物特征;其次,构建由Swin Transformer与改进的双向特征金字塔网络(EBiFPN)组成的检测框架,结合Swin Transformer的特征提取能力和EBiFPN的双向融合加权机制,显著提升多尺度异物检测精度及边界框定位性能。

1基于VAE-Swin Transformer的输电线异物检测网络

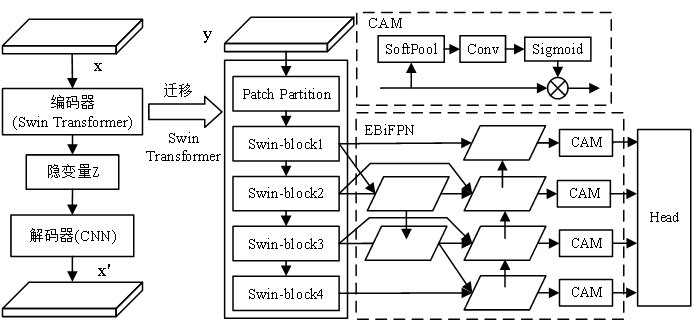

本文提出的基于VAE-Swin Transformer的输电线异物检测网络如图1所示。首先,使用Swin Transformer网络作为编码器、CNN网络作为解码器构建VAE预训练模型。使用大量无标注的输电线图片输入VAE预训练模型,通过编码器从输电线大数据集提取隐变量,解码器重构特征并最小化重构损失。VAE通过在编码器和解码器之间引入的隐变量z,并通过训练使隐变量![]() 的分布接近于先验分布,有效地增强了编码器在面对新数据时的鲁棒性。其次,异物检测网络由预训练后迁移得到的Swin Transformer网络与EBiFPN组成,进行小样本的输电线异物检测微调训练。其中Swin Transformer网络通过四层ST-block模块分层提取多尺度特征,EBiFPN则采用双向融合和动态加权策略增强多尺度特征交互,最终实现高精度的异物目标定位与检测。该网络借鉴了Swin Transformer在局部和全局特征提取方面的优势,利用了EBiFPN在多尺度特征融合中的双向融合策略和动态加权机制,既解决了输电线异物检测中目标尺度不同的问题,又解决了目标检测时精确定位边界框的问题。

的分布接近于先验分布,有效地增强了编码器在面对新数据时的鲁棒性。其次,异物检测网络由预训练后迁移得到的Swin Transformer网络与EBiFPN组成,进行小样本的输电线异物检测微调训练。其中Swin Transformer网络通过四层ST-block模块分层提取多尺度特征,EBiFPN则采用双向融合和动态加权策略增强多尺度特征交互,最终实现高精度的异物目标定位与检测。该网络借鉴了Swin Transformer在局部和全局特征提取方面的优势,利用了EBiFPN在多尺度特征融合中的双向融合策略和动态加权机制,既解决了输电线异物检测中目标尺度不同的问题,又解决了目标检测时精确定位边界框的问题。

图1. 基于VAE-Swin Transformer的检测网络

Figure 1. Detection network based on VAE-Swin Transformer

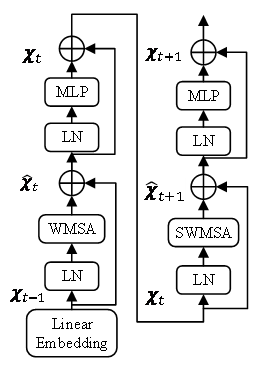

每层ST-block模块结构如图2所示。首先通过Linear Embedding将输入图像划分为固定大小的图像块并降低空间维度,实现多尺度特征处理;随后采用窗口自注意力机制(WMSA)和滑动窗口自注意力机制(SWMSA)提取局部与全局特征。WMSA计算过程如公式(1)所示:

![]() (1)

(1)

式中![]() 、

、![]() 与

与![]() 为分别为注意力机制的Query、Key与Value矩阵,

为分别为注意力机制的Query、Key与Value矩阵,![]() 为位置编码,

为位置编码,![]() 为缩放因子。SWMSA在WMSA基础上加入滑动窗口思想,打破相邻窗口的孤立性,实现跨区域全局特征交互。层归一化(LN)用于稳定训练过程并加速收敛,保持各层输出在合理范围内;多层感知机(MLP通过两层全连接层与GELU激活函数增强非线性表达能力。

为缩放因子。SWMSA在WMSA基础上加入滑动窗口思想,打破相邻窗口的孤立性,实现跨区域全局特征交互。层归一化(LN)用于稳定训练过程并加速收敛,保持各层输出在合理范围内;多层感知机(MLP通过两层全连接层与GELU激活函数增强非线性表达能力。

图2. ST-block结构

Figure 2.block structure

为提高模型在多尺度目标上的检测能力,本文在BiFPN[7]的基础上引入通道注意力机制(CAM),增强了对不同尺度特征的选择能力并提升信息传递效率。EBiFPN使用双向跨尺度连接架构,通过自下而上与自上而下的双向信息传递路径,实现多层级特征的深度交互与融合;同时增加横向连接,减少了特征信息的损失。EBiFPN在每层输出端加入CAM模块,CAM由SoftPool、卷积层、sigmoid激活函数和残差网络组成。SoftPool对特征进行平滑降维,保留关键细节的同时抑制噪声;卷积层则负责提取关键特征;sigmoid激活函数用于生成特征通道的权重;残差连接将原始特征与加权后特征融合,避免梯度退化并保障信息完整性。CAM模块提高了网络特征选择的准确性和信息传递的效率,进一步增强EBiFPN的表现。

2 实验与分析

2.1实验数据集与实验环境

本文使用无标注的输电线图片2484张,有悬挂物标注的输电线异物图片462张,有鸟巢标注的输电线异物图片353张最后将所有图片通过镜像、旋转扩充后按3:1:1的比例划分为训练集、测试集和验证集。所有实验使用Pytorch框架实现,硬件环境为A800显卡,32G内存,80G显存,32核CPU。

2.2模型评价指标

本文使用平均准确率(Mean Average Precision, mAP)作为模型性能的评估标准,其检测有效性通过交并比(Intersection over Union, IoU)阈值进行判定。当模型预测的边界框与真实标注框之间的IoU值超过预设阈值时,该检测结果被认定为有效。本文设置阈值为0.5和0.75两个严格度递对应的平均准确率分别为mAP50和mAP75,衡量模型在目标识别准确性及边界框回归精确性上的综合能力。

2.3实验结果与分析

为验证基于VAE-Swin Transformer输电线异物检测网络的优势,将其与Swin Transformer和YOLOv5进行对比,仿真结果如表1所示。

表1 实验结果

Table1 Experimental result

模型 | mAP50 | mAP75 |

Swin Transformer | 69.5% | 49.4% |

SSD | 70.2% | 51.5% |

YOLO v5 | 80.8% | 54.2% |

本文模型 | 82.5% | 56.8% |

由表1可知,Swin Transformer网络在小样本数据集中,检测精度受到一定限制,准确率mAP50和mAP75均低于其它模型。SSD和YOLO v5作为单阶段目标检测模型,其轻量化网络结构和参数优化策略,使得在小样本训练中展现出较强的适应能力,SSD的mAP50达到70.2%,mAP75达到51.5%,YOLO v5的mAP50达到80.8%,mAP75达到54.2%。本文模型在mAP50和mAP75指标上均表现优异,分别达到了82.5%和56.8%,相较于其他主流检测模型实现了显著提升。综合来看,本文模型使用VAE结构对Swin Transformer预训练提升了其在小样本训练中的鲁棒性,有效缓解了Swin Transformer在小样本场景下的过拟合问题,降低了Swin Transformer在小样本异物检测任务中的训练难度,检测性能显著提升。与EBiFPN的结合得到了更好的输电线异物检测效果,验证了EBiFPN模块能有效提升模型的多尺度特征融合能力,进而提升模型在多尺度目标以及复杂背景下的检测性能。图3检测效果图,其中黄色框为真值框,蓝色为模型检测框。

Swin Transformer SSD

YOLO v5 本文模型

图3.目标检测效果图

Figure3. Target detection effect diagram

3总结

本文针对输电线异物检测样本量小、所处背景复杂等问题,提出了一种基于VAE-Swin Transformer的输电线异物检测网络。首先利用VAE预训练框架解决Swin Transformer小样本训练难度高、过拟合的问题,提高Swin Transformer特征提取能力,使其滑动窗口自注意力机制得以充分发挥效果;其次,本文将VAE-Swin Transformer与改进的双向特征金字塔将结合,通过CAM进一步提升模型的特征融合能力,实现Swin Transformer在小样本数据下对输电线异物的精准定位。通过Swin Transformer、SSD和YOLOv5模型对比,结果表明本文模型在mAP50和mAP75指标上均高于其它模型,验证了本文模型在输电线异物检测任务中的有效性和潜在应用价值。

参考文献

和敬涵,罗国敏,程梦晓.新一代人工智能在电力系统故障分析及定位中的研究综述.中国电机工程学报,2020, 40(17):5506-5515.doi:10.13334/j.0258-8013.pcsee.200032

REN S, HE K, GIRSHICK R, et al. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[J].IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(6):1137-1149.doi:10.1109/TPAMI.2016.2577031

REDMON J, FARHADI A. YOLOv3: An Incremental Improvement[J].arXiv e-prints, 2018.doi:10.48550/arXiv.1804.02767

LIU Z, LIN Y and CAO Y.Swin Transformer: Hierarchical Vision Transformer using Shifted Windows.2021.doi:10.48550/arXiv. 2103.14030.

VASWANI A, SHAZEER N,PARMAR N,et al.Attention Is All You Need[J].arXiv,2017. doi:10. 48550/ arXiv.1706.03762.

PING T P J .Degradation feature extraction using multi-source monitoring data via logarithmic normal distribution based variational auto-encoder[J].Computers in Industry, 2019, 109.doi:10.1016/j.compind.2019.04.013

TAN M , PANG R , LE Q V .EfficientDet: Scalable and Efficient Object Detection[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).IEEE, 2020.doi:10.1109/CVPR42600.2020.01079.